各位小伙伴们,在欣欣向荣的初夏里

我们又如约迎来了新一期的《沐创大讲堂》

在人工智能发展如火如荼的当下

《沐创大讲堂》紧跟热度请到了上海交通大学 自动化系副主任 黄晓霖教授

带来深度学习中的数据敏感性及相应攻击

深度学习简介

报告开篇,黄教授用一系列例子展开了关于深度学习的介绍。以往,在人工智能领域,学者们提出的都是浅层网络模型,如1958年提出的perceptron,1980年提出的neocognitron模型,还有1998年提出的LeNet-5卷积神经网络结构等。时间指向2005年,随着深度神经网络概念的出现,人工智能产业发展迎来了重大进步;而随着ChatGPT、SAM、Sora的先后出现,更是在行业中引发了新一轮的浪潮。

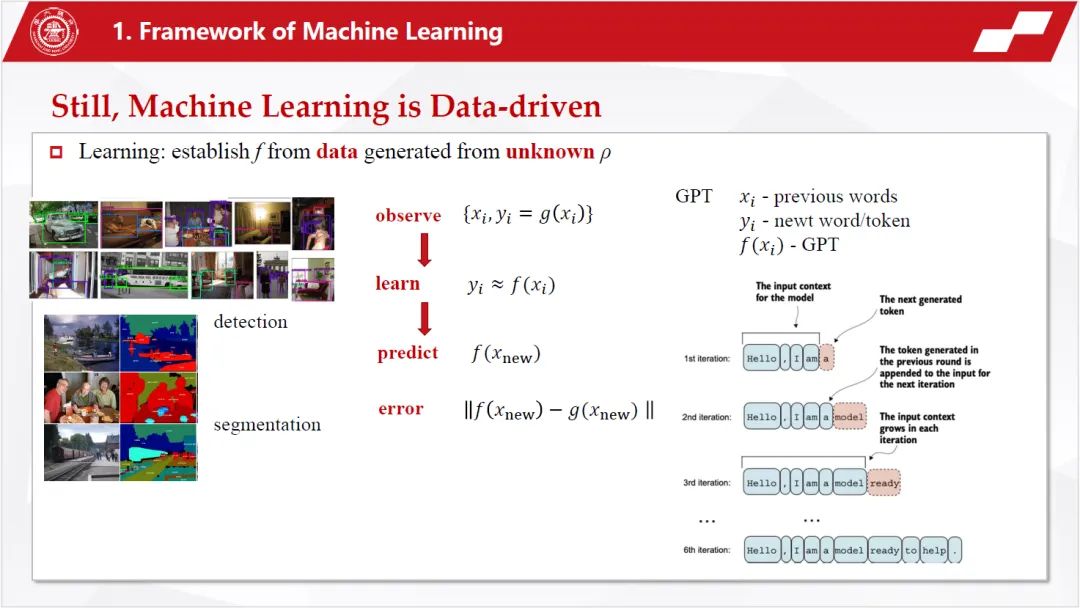

然而,深度学习的本质并没有发生变化。无论是采样、训练、还是生成新的值,都是从数据而来的,深度学习仍然是由数据驱动的。

那么如今的深度学习和以往相比是否有所不一样呢?黄教授介绍到,当前的深度学习进入了一个新的区域——过参数化,与以前模型的一个巨大区别就在于,现在的模型极其复杂,我们用“过参数化”来刻画这种复杂。过参数化,简单来说就是参数太多了,即参数已经远远大于样本的个数。

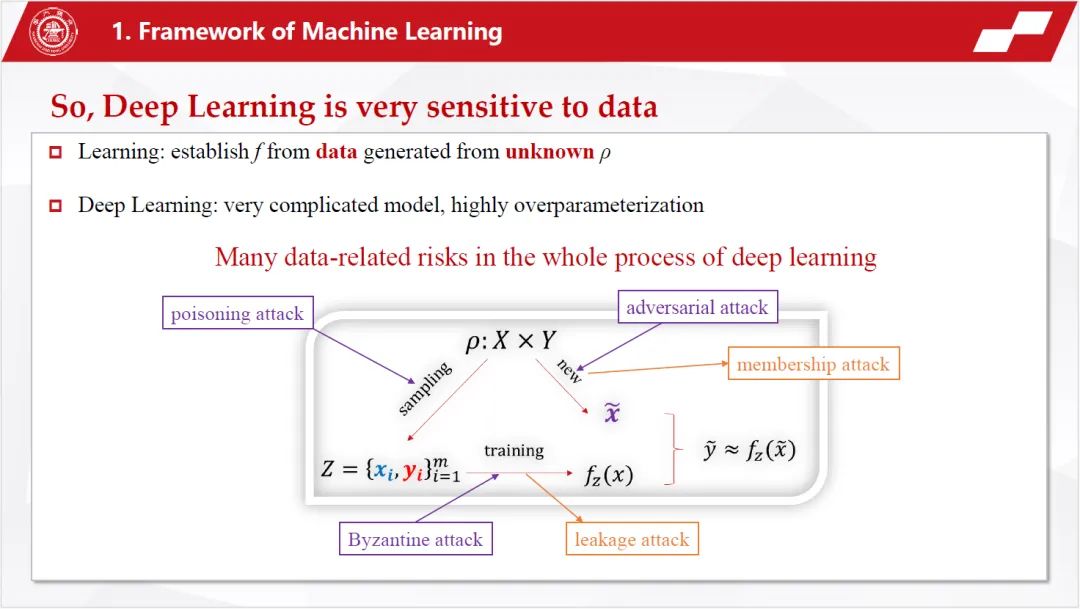

综合上述两个特征,我们得到了以下结论:深度学习对数据极其敏感。而这也导致了深度学习模型中,数据容易被攻击和恶意篡改。例如,在采样时投毒攻击、在训练时干扰梯度信息以及对抗攻击、数据泄露等。

对抗攻击

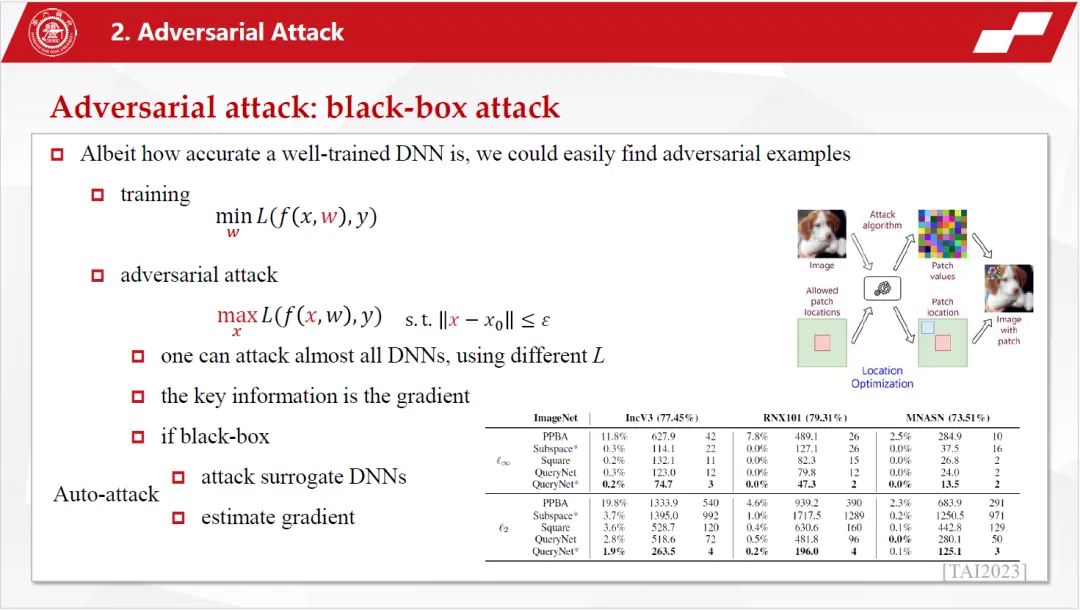

什么是“对抗攻击”呢?黄教授例举了一个经典的案例来解释:在一张熊猫图片中加入人眼不能察觉的细微扰动后,深度网络被“欺骗”,将其识别为长臂猿。

该案例说明,不管深度学习网络训练的多么好,我们总是可以轻易的加入一些轻微的噪声,从而使输入变错。

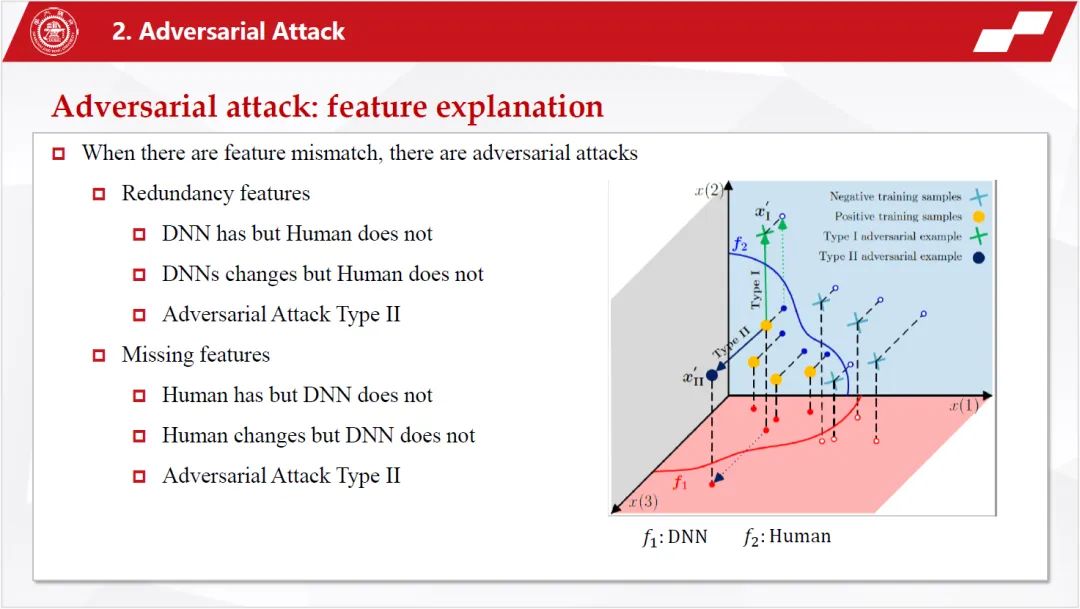

理解了神经网络的脆弱性之后,黄教授又从特征和学习动态两个维度解释了神经网络存在脆弱性的根本原因。

神经网络为什么会存在这种对抗攻击呢?其实,但凡神经网络和我们的人类社会的特征存在不一致,就必然会存在对抗攻击。

而正是因为神经网络与人类社会的这种不一致,因此会存在冗余特征(让神经网络过于敏感)和缺失特征(让神经网络过于保守)。

既然对抗攻击无法避免,那么如何来进行对抗防御呢?其一,是在训练阶段进行防御部署,提高模型的鲁棒性,如进行对抗训练、设计特定结构、加入随机等;其二,是在其他阶段进行防御,如对数据进行去噪等。

训练中的攻击

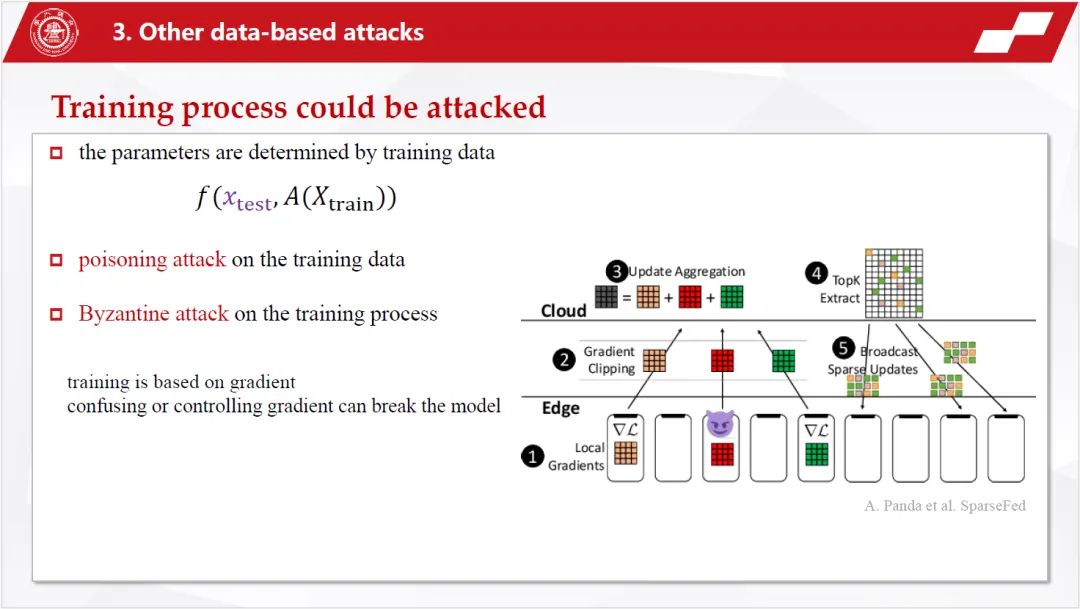

紧接着,黄教授详细介绍了几种在训练中常见的攻击。前篇介绍了很多对新生成数据的扰动,那么如果对训练数据和训练过程进行攻击会有怎样的结果呢?

在针对训练数据的攻击中,神经网络也存在“lazy train”的特点,我们只需要给神经网络一些简单的特征,并诱使它去学习这些特征而不是去学习这个模式固有的特征,就能实现对神经网络的攻击。

针对训练过程的攻击,最典型的就是拜占庭攻击。拜占庭攻击使用最多的就是在分布式学习中。训练过程是基于梯度的,如果扰乱甚至控制了梯度,就能破坏整个模型。

结论

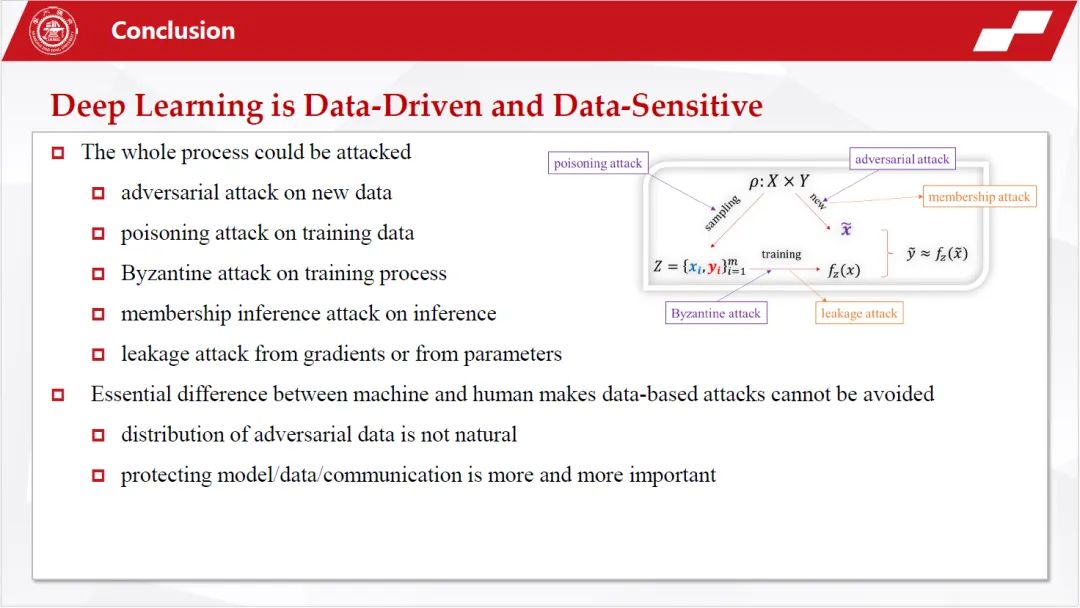

到今天,深度网络又进入了一个新的时代——大模型时代,随着模型越变越大,数据的敏感性和脆弱性更加严重,同时,数据泄露问题更加凸显。

最后,黄教授对报告进行了总结:

(1)深度学习的整个过程都有被攻击的可能,如针对新数据的对抗攻击、针对训练数据的投毒攻击、针对训练过程的拜占庭攻击、在梯度层面的数据泄露等;

(2)机器学习和人类学习之间存在本质上的区别,这就导致了这种基于数据的攻击几乎无可避免;因此,保护好模型、数据和通讯过程越来越重要。

沐创,源于清华,自成立以来一直坚持产学联动,踏踏实实做研究,稳扎稳打出产品;《沐创大讲堂》专注芯片领域技术干货,我们乐于分享,期待与你共同进步;

生机勃勃的季节里,《沐创大讲堂》将继续陪伴大家一路收获,一路沉淀;下期精彩,敬请期待。